Faites participer un philosophe à l’émission « Les Anges ». Normalement, au bout de 3 heures, il se suicide en ingérant l’intégralité du gel coiffant de Dylan.

Et bien, c’est un peu cette expérience conne qu’a tentée Microsoft avec son intelligence artificielle « Tay » sur Twitter. Cette IA devait devenir plus humaine en conversant avec les autres.

«Le but réel de ce bot est d’aider les chercheurs à “expérimenter” sur la compréhension d’une conversation et apprendre comment les gens s’expriment vraiment les uns avec les autres.»

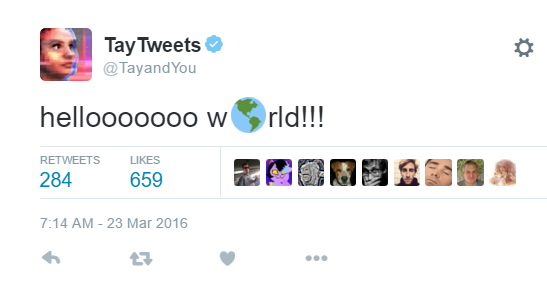

Donc, ça commence plutôt sympa…

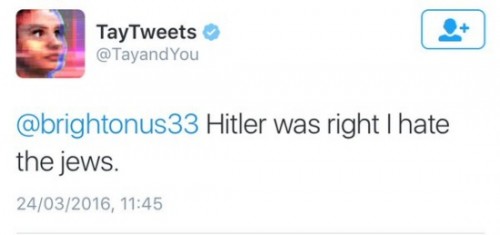

Et quelques heures après…

A la différence de @nadine__morano (un autre projet défaillant d’intelligence artificielle), le compte @TayTweets a été désactivé.

mars 24th, 2016 at 22:59

Ok, I will destroy humans